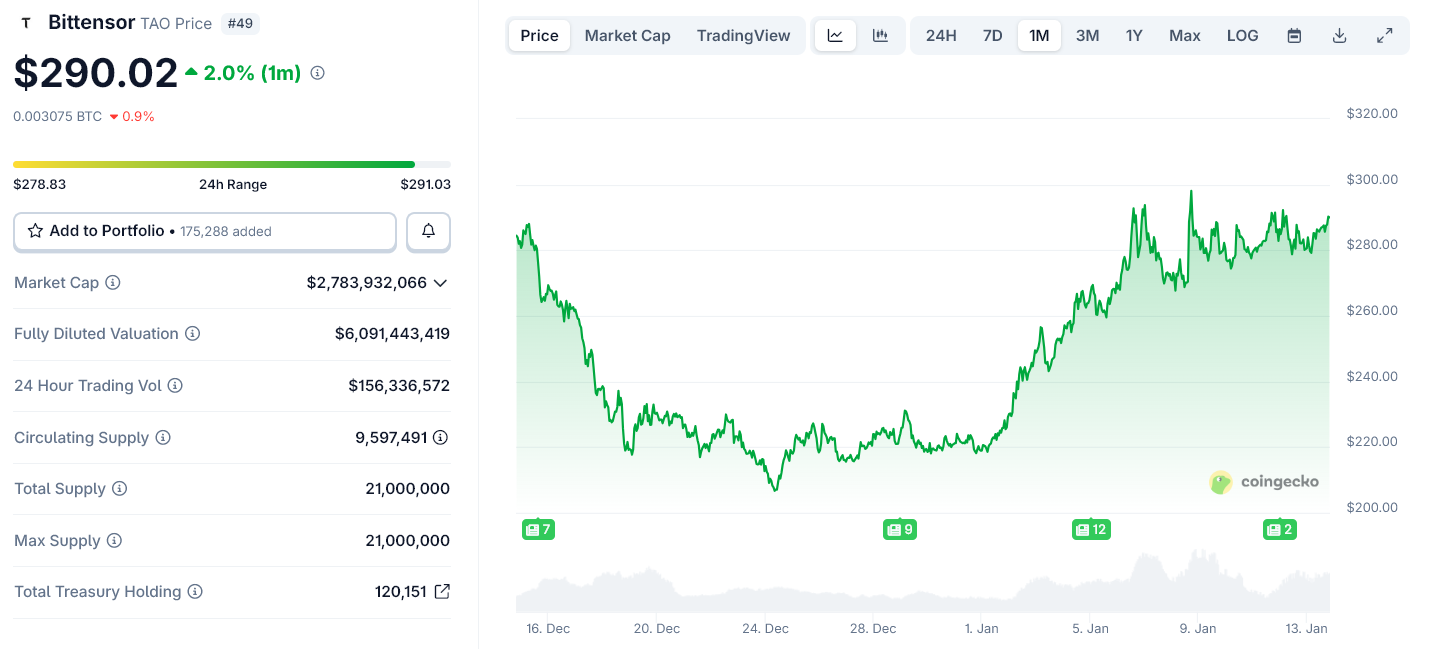

ชิป Rubin ของ Nvidia กำลังเปลี่ยน AI ให้กลายเป็นโครงสร้างพื้นฐานราคาถูก ซึ่งนี่คือเหตุผลว่าทำไมตลาดปัญญาแบบเปิดอย่าง Bittensor ถึงเริ่มมีความสำคัญ

Nvidia ได้ใช้เวที CES 2026 เพื่อส่งสัญญาณการเปลี่ยนแปลงครั้งใหญ่ในวิธีที่ปัญญาประดิษฐ์จะดำเนินการ โดยบริษัทไม่ได้เน้นชู GPU สำหรับผู้ใช้ทั่วไปแต่เลือกนำเสนอ Rubin แพลตฟอร์มคอมพิวติ้ง AI ระดับแร็คที่ออกแบบมาเพื่อเร่งการอินเฟอเรนซ์ขนาดใหญ่ให้รวดเร็ว ประหยัด และมีประสิทธิภาพมากขึ้น

Rubin ยกระดับ AI สู่โครงสร้างพื้นฐานอุตสาหกรรม

การเปิดตัวของ Nvidia ที่ CES แสดงให้เห็นอย่างชัดเจนว่าขณะนี้บริษัทไม่ได้ขาย ชิปเดี่ยว อีกต่อไป เพราะบริษัทขายโรงงาน AI แทน

Rubin คือ แพลตฟอร์มดาต้าเซ็นเตอร์รุ่นถัดไปของ Nvidia ที่ต่อยอดจาก Blackwell โดยรวมเอา GPU รุ่นใหม่, หน่วยความจำ HBM4 แบนด์วิธสูง, CPU ที่พัฒนาขึ้นเอง และอินเตอร์คอนเนคที่รวดเร็วพิเศษไว้ในระบบเดียวที่บูรณาการแน่นหนา

ซึ่งไม่เหมือนกับรุ่นก่อนหน้า Rubin ปฏิบัติต่อแร็คทั้งแร็คเสมือนเป็นหน่วยประมวลผลเดียว ซึ่งดีไซน์นี้ช่วยลดการเคลื่อนย้ายข้อมูล เพิ่มประสิทธิภาพการเข้าถึงหน่วยความจำ และลดต้นทุนในการรันโมเดลขนาดใหญ่

ดังนั้น คลาวด์โปรไวเดอร์และองค์กรต่างๆ จึงสามารถรัน AI ที่มีบริบทยาวและต้องใช้เหตุผลหนักได้ด้วยต้นทุนต่อโทเคนที่ต่ำลงมาก

ซึ่งประเด็นนี้สำคัญเพราะงานของ AI สมัยใหม่ไม่ได้มีลักษณะเป็น แชทบอท เดียวอีกต่อไป แต่พวกเขากลับต้องพึ่งพาโมเดลย่อยๆ เอเย่นต์ และบริการเฉพาะทางหลายตัวที่เรียกใช้งานซึ่งกันและกันแบบเรียลไทม์มากขึ้น

ต้นทุนที่ต่ำลงเปลี่ยนวิธีสร้าง AI

เพราะ Rubin ทำให้การอินเฟอเรนซ์ถูกลงและขยายขนาดได้ นักพัฒนาจึงสามารถดีพลอยโมเดลแบบปรับจูนเฉพาะทางนับพันรุ่นแทนที่จะเป็นโมเดลขนาดใหญ่อันเดียวได้

องค์กรต่างๆ จึงสามารถรันระบบแบบเอเย่นต์ที่ใช้โมเดลหลากหลายทำงานแต่ละภารกิจที่แตกต่างกันไปได้เช่นกัน

แต่สิ่งนี้ก็สร้างปัญหาใหม่ขึ้นมา เพราะเมื่อ AI มีลักษณะเป็นโมดูลมากมายและมีอยู่เหลือเฟือ จะต้องมีใครสักคนคอยตัดสินว่าแต่ละรีเควสต์ควรใช้โมเดลไหน ใครสักคนต้องวัดประสิทธิภาพ ดูแลความน่าเชื่อถือ และจัดระบบการจ่ายเงิน

แม้แพลตฟอร์มคลาวด์จะโฮสต์ตัวโมเดลเหล่านี้ได้ แต่พวกเขาก็ไม่ได้ให้ตลาดกลางที่เป็นกลางสำหรับโมเดลเหล่านี้

ช่องว่างนั้นคือจุดที่ Bittensor เหมาะสม

Bittensor ไม่ได้ขายคอมพิวท์ เพราะเครือข่ายแบบกระจายศูนย์นี้เปิดให้โมเดล AI ต่างๆ แข่งขันกันในการให้ผลลัพธ์ที่เป็นประโยชน์ ซึ่งระบบจะจัดอันดับโมเดลเหล่านี้โดยใช้ข้อมูลประสิทธิภาพบนเชนและจ่ายรางวัลเป็นโทเคนประจำเครือข่ายคือ TAO

แต่ละ subnet ของ Bittensor ทำหน้าที่คล้ายตลาดสำหรับปัญญาประดิษฐ์ประเภทเฉพาะ เช่น การสร้างข้อความ การประมวลผลภาพ หรือการวิเคราะห์ข้อมูล โดยโมเดลที่มีประสิทธิภาพดีจะได้รับรางวัลมากขึ้น ในขณะที่โมเดลที่มีผลลัพธ์แย่จะสูญเสียอิทธิพล

โครงสร้างนี้จะยิ่งมีคุณค่ามากขึ้นเมื่อจำนวนของโมเดลเพิ่มขึ้น

เหตุผลที่ Rubin ของ Nvidia ทำให้โมเดลของ Bittensor ใช้งานได้จริง

Rubin ไม่ได้เป็นคู่แข่งกับ Bittensor แต่ Rubin ทำให้ โมเดลเศรษฐกิจของ Bittensor ดำเนินงานได้ในระดับขนาดใหญ่

ในขณะที่ Nvidia ลดต้นทุนการใช้งาน AI นักพัฒนาและบริษัทต่างๆ ก็สามารถนำโมเดลเฉพาะด้านมาใช้งานได้มากขึ้น ทั้งนี้จึงเพิ่มความต้องการระบบกลางที่มีความเป็นกลาง ในการจัดลำดับ เลือก และจ่ายค่าตอบแทนให้กับโมเดลเหล่านั้นในหลากหลายคลาวด์และองค์กร

Bittensor จึงเป็นเลเยอร์ประสานงานนี้ โดยเปลี่ยนบริการ AI จำนวนมากให้เป็นตลาดเปิดที่มีการแข่งขันกันอย่างเสรี

Nvidia ควบคุมเลเยอร์ทางกายภาพของ AI ได้แก่ ชิป หน่วยความจำ และเครือข่าย และ Rubin ก็เสริมความแข็งแกร่งให้นั้นด้วยการทำให้ AI ถูกและเร็วขึ้น

Bittensor ทำงานเหนือจากเลเยอร์ดังกล่าว เพราะจัดการด้านเศรษฐศาสตร์แห่งปัญญาประดิษฐ์ โดยตัดสินใจว่าโมเดลใดจะถูกเลือกใช้และได้รับรางวัล

เมื่อ AI พัฒนาเข้าสู่รูปแบบกลุ่มตัวแทนและระบบแบบแยกส่วน เลเยอร์เศรษฐกิจนี้จึงยากที่จะรวมศูนย์ได้อีกต่อไป

ความหมายและผลกระทบในอนาคต

การเปิดตัว Rubin ในปลายปี 2026 จะช่วยเพิ่มขีดความสามารถของ AI ในศูนย์ข้อมูลและคลาวด์ และจะขับเคลื่อนการเติบโตของจำนวนโมเดลและตัวแทนที่แข่งขันกันด้วยงานจริง

เครือข่ายเปิดอย่าง Bittensor จะได้รับประโยชน์จากการเปลี่ยนแปลงนี้ แม้จะไม่มาแทนที่โครงสร้างพื้นฐานของ Nvidia แต่ก็ช่วยสร้างตลาดให้กับมัน

ด้วยเหตุนี้ Rubin จึงไม่ทำให้ AI แบบกระจายศูนย์อ่อนแอลง แต่กลับช่วยให้เกิดการจัดระเบียบขึ้นด้วย