ก่อนที่เราจะไปดูกันว่า Auto-GPT คืออะไร ถ้าจะให้นิยามง่าย ๆ Auto-GPT เป็นเครื่องมือที่จะสามารถพลิกโฉมสิ่งต่าง ๆ ได้ด้วยการช่วยให้แบบจำลองทางภาษาขนาดใหญ่ (Large Language Models) สามารถคิด, วางแผน, และดำเนินงานต่างๆ ได้โดยไม่ต้องมีการป้อนข้อมูลใดๆ จากมนุษย์ ซึ่งเปรียบเสมือนผู้ช่วยอัจฉริยะที่ทำงานได้โดยอัตโนมัติ และ เป็นพี่น้องของ ChatGPT ที่มีความเป็นอัตโนมัติมากกว่า

มีเสียงกระซิบมาว่า Auto-GPT นั้นจะเป็นจุดเริ่มต้นของ AGI (Artificial General Intelligence) อย่างไรก็ตาม แทนที่จะมาพูดคุยกันในสิ่งที่ยังไม่เกิดขึ้น เรามาโฟกัสในสิ่งที่เรารู้กันก่อนดีกว่า ในบทความนี้ เราจะมาสำรวจในทุกข้อมูลที่เราต้องรู้เกี่ยวกับ Auto-GPT ทั้งความสามารถของมัน และ วิธีการที่มันจะมาเปลี่ยนแนวทางของการโต้ตอบระหว่างเราและปัญญาประดิษฐ์

หากคุณเชื่อว่า AI จะกลายมาเป็นอนาคตของเรา มาเข้าร่วมกลุ่มคนรักคริปโตอย่าง BeInCrypto Trading Community บน Telegram สิ: เรียนรู้สิ่งต่างๆ มากมายเกี่ยวกับสกุลเงินแห่งอนาคตและระบบการกระจายอำนาจ, มาเรียนรู้คอร์สพื้นฐานการซื้อขายฟรี และสอบถามข้อมูลต่างๆ ที่คุณต้องการจากทีมงานนักเทรดมืออาชีพของเรา!

Auto-GPT คืออะไร?

Auto-GPT เป็นผู้ช่วย AI ที่มุ่งเน้นในเรื่องความเป็นอัตโนมัติ อินเตอร์เฟสทดลองสำหรับ GPT-4 และ GPT-3.5 นี้จะสามารถทำงานได้อัตโนมัติโดยไม่ต้องมีการแทรกแซงจากมนุษย์ แตกต่างจาก ChatGPT ที่ต้องใช้ชุดคำสั่งที่เฉพาะเจาะจงในการดำเนินการ Auto-GPT จะเข้ามาจัดการโดยการสร้างชุดคำสั่งด้วยตัวมันเองเพื่อให้สามารถทำงานที่คุณตั้งเอาไว้ให้สำเร็จ

ลองคิดอย่างนี้: เพื่อปลดปล่อยพลังที่แท้จริงของแชทบอท AI อย่าง ChatGPT คุณจะต้องมีการปรับแต่งข้อความเล็กน้อยก่อนที่จะป้อนเข้าไป เพราะคุณภาพของผลลัพท์ที่ได้จาก ChatGPT จะขึ้นอยู่กับคุณภาพของชุดคำสั่ง (Text Prompt) ที่คุณป้อนเข้าไป แต่มันจะเป็นอย่างไร หากเราปล่อยให้แอปช่วยคิดชุดคำสั่งที่ดีที่สุดด้วยตัวมันเอง? และยกระดับขึ้นไปอีกขั้น ด้วยการให้มันคิดถึงขั้นตอนต่างๆ ที่ตามมาและวิธีการดำเนินการ, ดำเนินการซ้ำไปซ้ำมาจนกระทั่งงานนั้นสำเร็จลุล่วง และนั่นคือสิ่งที่ Auto-GPT ตั้งเป้าเอาไว้

และไม่ใช่แค่เพียงความฉลาดเท่านั้น แต่มันยังเป็นเรื่องของไหวพริบอีกด้วย Auto-GPT สามารถเข้าใช้งานเว็บไซต์และเครื่องมือค้นหาต่าง ๆ, รวบรวมข้อมูล, และประเมินคุณภาพของข้อมูลนั้นได้ด้วยตนเอง ข้อมูลย่อย ๆ จะได้รับการเสริมความ จากนั้น Auto-GPT จะกลับไปที่บอร์ดภาพรวมดิจิทัลเพื่อสร้างภารกิจย่อยใหม่เพื่อค้นหาข้อมูลที่ดียิ่งขึ้น ดังนั้น มันจึงได้รับการขนานนามว่าเป็น ผู้ช่วยอัจฉริยะที่สามารถทำงานได้อัตโนมัติ

ฟังดูน่าสนใจไหมครับ? ถ้าอยากลองใช้งาน จะต้องใช้งานบัญชี OpenAI แบบชำระเงิน จากนั้นใช้งาน OpenAI API ซึ่งจะทำหน้าที่เป็นสะพานเชื่อมที่ช่วยให้ Auto-GPT โต้ตอบกับ GPT-4 และ ChatGPT ของ OpenAI ได้

สำหรับเรื่องค่าใช้จ่าย จะต้องใช้เป็นโทเค็น ซึ่งเป็นสกุลเงินของ OpenAI หนึ่งโทเค็นจะมีมูลค่าคร่าวๆ ประมาณ 4 ตัวอักษรหรือ 0.75 คำ จำนวนของโทเค็นที่คุณต้องจ่ายทั้งหมดจะเป็นจำนวนรวมของคำจากชุดคำสั่งที่คุณส่งเข้าไปและผลลัพท์ที่ได้มา

สิ่งสำคัญที่จะต้องเตรียมตัวเพื่อเริ่มใช้งาน Auto-GPT

ไม่เหมือนกับ ChatGPT ที่คุณสามารถเข้าถึงได้ง่าย ๆ ด้วยการเข้าใช้บัญชี OpenAI และทำตามขั้นตอนพื้นฐานไม่กี่ขั้นตอน การใช้งาน Auto-GPT บนคอมพิวเตอร์ของคุณจะมีกระบวนการที่ซับซ้อนกว่าเล็กน้อย และนี่คือสิ่งที่คุณต้องทำ:

- ขั้นตอนที่ 1: ก่อนอื่น ต้องมีพื้นฐานโค้ดที่ดี ซึ่งนั่นรวมไปถึง Python 3.8 (หรือใหม่กว่า) และ OpenAI API key คุณสามารถค้นหาลิ้งก์ดาวน์โหลดเหล่านี้ได้ในหน้า GitHub ของ Auto-GPT

- ขั้นตอนที่ 2: ติดตั้งเครื่องมือแล้วใช่มั้ย? ยอดเยี่ยม! ตอนนี้ ไปที่ GitHub คลิก ‘Code’ และดาวน์โหลดไฟล์ Zip เลือกตัวเลือก ‘Stable’ ที่ทางด้านซ้าย — ‘Master’ อาจจะดูเอาแน่เอานอนไม่ได้เล็กน้อย

- ขั้นตอนที่ 3: เปิด Power Shell และเรียกใช้โค้ดนี้: git clone https://github.com/Torantulino/Auto-GPT.git’

- ขั้นตอนที่ 4: ตอนนี้ ไปที่ไดเร็กทอรีของโปรเจกต์ด้วย: ‘cd Auto-GPT’

- ขั้นตอนที่ 5: เมื่อคุณมาถูกที่แล้ว ให้ติดตั้งไลบรารีด้วยคำสั่งนี้: ‘pip install -r specifications.txt’

- ขั้นตอนที่ 6: สุดท้าย เปลี่ยนชื่อ ‘env. template’ เป็น ‘.env’ และป้อน OPENAI_API_KEY ของคุณ

เรียบร้อย! Auto-GPT พร้อมใช้งานแล้ว ตั้งชื่อให้กับบอทของคุณและเริ่มใช้งานมันได้เลย

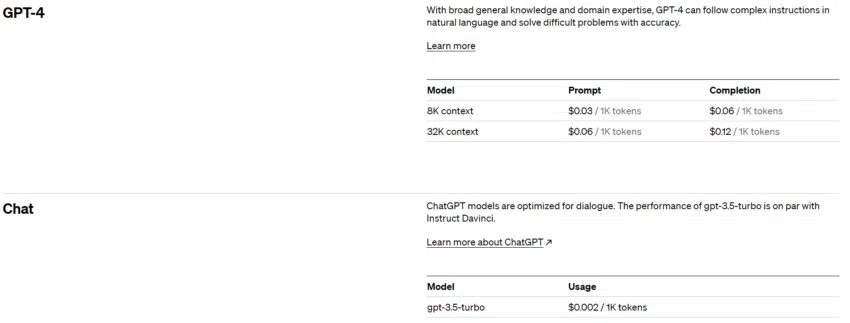

สำหรับ OpenAI APIs มีตัวเลือกให้เลือกอยู่ 2 ตัวในขณะที่เขียนบทความนี้ — 8,000 บริบท และ 32,000 บริบท ดังที่เห็นได้ในภาพด้านล่าง ราคาจะขึ้นอยู่กับรุ่นที่คุณเลือกและอาจจะแพงมากหากคุณไม่ระวังให้ดี เราจะมาพูดคุยกันในเรื่องข้อเสียเหล่านี้โดยละเอียดในภายหลัง

อย่างไรก็ตาม คุณไม่จำเป็นต้องกังวลมากว่ามันจะทำให้คุณถังแตกได้ คุณสามารถกำหนดวงเงินการใช้จ่ายกับ API ได้ตามที่คุณต้องการ หากคุณตั้งค่าขีดจำกัดแบบ Soft OpenAI จะส่งอีเมลแจ้งเตือนคุณว่าคุณได้ใช้งานถึงขีดจำกัดที่ตั้งเอาไว้แล้ว ส่วนการตั้งค่าขีดจำกัดแบบ Hard มีประสิทธิภาพมากกว่า เนื่องจาก OpenAI จะระงับบริการที่เกี่ยวข้องกับ API ทั้งหมดโดยอัตโนมัติเมื่อคุณใช้งานถึงขีดจำกัดแล้ว

“บริบท” ในแบบจำลองทางภาษาขนาดใหญ่ (LLM) คืออะไร?

“บริบท” ในที่นี้หมายถึง “ข้อความ” หรือ ”ข้อมูล” ทั้งหมดที่อยู่ก่อนหน้าที่แบบจำลองใช้เพื่อสร้างการตอบโต้ คุณเข้าใจกระบวนการของการสนทนาใช่หรือไม่ ที่คุณต้องจดจำสิ่งที่พูดหรือได้ยินเพื่อให้คุณโต้ตอบตามนั้นได้และนั่นเป็นวิธีที่ GPT-4 และแบบจำลองทางภาษาอื่นๆ ทำงานเช่นกัน พวกมันจะใช้สิ่งที่เราเรียกว่า “บริบท” ซึ่งเป็นข้อความทั้งหมดที่อยู่ก่อนหน้า เพื่อคำนวนว่าจะพูดอะไรต่อไป

ลองนึกภาพว่าคุณจำได้แค่ 2 ประโยคสุดท้ายของการสนทนา และนั่นจะเป็น “ข้อจำกัด” ของมัน แบบจำลอง AI เหล่านี้จึงจะมี “หน้าต่างบริบท” ซึ่งเปรียบเสมือนหน่วยความจำระยะสั้นของแบบจำลอง

ในช่วงเดือนพฤษภาคม 2023 GPT-4 สามารถจัดการข้อความได้มากกว่า 25,000 คำ ซึ่งเป็น “บริบท” ที่ยาวกว่าใน GPT รุ่นก่อนหน้าเป็นอย่างมาก

Auto-GPT: มาดูเบื้องหลังกันแบบคร่าว ๆ

ให้คิดซะว่า Auto-GPT เป็นผู้ช่วย AI แบบอัจฉริยะ คุณทำการมอบหมายภารกิจให้มัน แล้วให้มันระดมสมองเพื่อสร้างแผนการทำงานให้สำเร็จลุล่วง หากภารกิจจะต้องมีการท่องอินเตอร์เน็ตหรือดึงข้อมูล Auto-GPT จะปรับเปลี่ยนกลยุทธ์จนกว่าภารกิจจะสำเร็จ

มันเหมือนกับว่าคุณมีผู้ช่วยส่วนตัวที่สามารถจัดการงานต่างๆ ให้กับคุณ ตั้งแต่การวิเคราะห์ตลาด, การบริการลูกค้า, ไปจนถึงเรื่องการเงิน และอื่น ๆ อีกมากมายเท่าที่จะคิดได้

ต่อไปนี้คือฟันเฟืองที่สำคัญ 4 ตัวที่เป็นสิ่งที่ขับเคลื่อน Auto-GPT:

- สถาปัตยกรรม: Auto-GPT ใช้ประโยชน์จากจุดแข็งของสถาปัตยกรรมปัญญาประดิษฐ์ในรุ่น GPT-4 และ GPT-3.5 เป็นเครื่องมือในการสร้างความรู้ความเข้าใจ และ ช่วยในการคิดและการแก้ปัญหา

- ความสามารถในการทำงานอัตโนมัติ: นี่คือกลไกการพัฒนาตนเองของ Auto-GPT ซึ่งสามารถสะท้อนให้เห็นได้ถึงประสิทธิภาพของการใช้ประโยชน์จากข้อมูลที่ได้รับก่อนหน้าเพื่อส่งมอบผลลัพธ์ที่แม่นยำยิ่งขึ้นได้

- การจัดการหน่วยความจำ: การผสานรวมกับฐานข้อมูลเวกเตอร์ ซึ่งเป็นเหมือนกับคลังหน่วยความจำระยะยาวของบอท จะช่วยให้ Auto-GPT เก็บรักษาบริบทและตัดสินใจได้อย่างชาญฉลาดยิ่งขึ้น

- ความสามารถในการทำงานที่หลากหลาย: ด้วยความสามารถต่างๆ เช่น การจัดการไฟล์, การท่องเว็บ, และการรวบรวมข้อมูล Auto-GPT เป็นเครื่องมือที่สามารถทำงานได้หลายมิติ ซึ่งเป็นก้าวกระโดดจากพัฒนาการของ AI ในรุ่นก่อนหน้านี้

จากฟันเฟืองต่างๆ เหล่านี้ ทำให้ Auto-GPT เป็นบอทที่ใช้ประโยชน์จาก AI และ LLM เพื่อจัดการงานต่าง ๆ มากมาย, เรียนรู้จากอดีตของมัน และทำการเสริมประสิทธิภาพให้กับตนเองอย่างต่อเนื่อง

อย่างไรก็ตาม เราจะต้องจดจำไว้เสมอว่า ความเป็นไปได้มากมายที่ดูจะน่าตื่นเต้นเหล่านี้อาจจะไม่ได้สะท้อนให้เห็นถึงความสามารถที่แท้จริงของ Auto-GPT ดังนั้น เรามาดูข้อจำกัดและความท้าทายบางประการที่ Auto-GPT ต้องเผชิญกันดีกว่า

ข้อจำกัดของ Auto-GPT

ปัจจัยเรื่องค่าใช้จ่าย

การใช้งาน GPT-4 ซึ่งเป็นหนึ่งในกรอบโครงสร้างของ Auto-GPT นั้นมีค่าใช้จ่ายค่อนข้างสูง ขั้นตอนของการสร้าง “ความรู้ความเข้าใจ” ในแต่ละขั้นตอนในลำดับของงานจะก่อให้เกิดค่าโทเค็นที่ GPT-4 จะต้องประมวลผลและดำเนินงานตามชุดคำสั่ง

ใน “หน้าต่างบริบท” ที่ 8,000 บริบท ค่าใช้จ่ายคือ 0.03 ดอลลาร์ต่อ 1,000 โทเค็นสำหรับชุดคำสั่ง และ 0.06 ดอลลาร์ต่อ 1,000 โทเค็นสำหรับผลลัพท์ที่ออกมา สมมุติว่ามีการใช้หน้าต่างบริบทสูงสุด แบ่งเป็นชุดคำสั่ง 80% และผลลัพท์ 20% แต่ละขั้นตอนจะมีค่าใช้จ่าย 0.288 ดอลลาร์

ตอนนี้ งานทั่วไปโดยเฉลี่ยจะมีได้มากถึง 50 ขั้นตอน (หรือมากกว่านั้น) นั่นหมายความว่า แม้แต่งานที่ค่อนข้างง่ายเพียงงานเดียวก็อาจจะมีค่าใช้จ่ายถึง (0.288 x 50) = 14.40 ดอลลาร์ ค่าใช้จ่ายในการประมวลผลที่ค่อนข้างแพงของ Auto-GPT นี้ทำให้ผู้ใช้งานและหน่วยงานต่างๆ ไม่สามารถนำมันไปใช้งานได้อย่างมีประสิทธิภาพ

ปัญหา “ติดอยู่ในลูปตลอดเวลา”

คุณอาจจะแย้งได้ว่า หาก Auto-GPT สามารถเพิ่มความคล่องตัวให้กับเวิร์คโฟลว์ของคุณและจัดการงานต่างๆ ได้สำเร็จ ถ้างั้น ค่าธรรมเนียมจำนวนมากของ OpenAI API อาจจะถูกมองว่าเป็นค่าใช้จ่ายที่สมเหตุสมผล แต่นั่นอาจจะไม่เป็นเช่นนั้นเสมอไป

ลองเข้าไปดูที่ subreddits อย่าง r/autogpt หรือฟอรัมในโลกออนไลน์อื่น ๆ ที่คล้ายกัน คุณจะพบว่ามีผู้ใช้งานจำนวนมากที่บ่นว่า Auto-GPT มักสะดุดขาตนเอง โดย Auto-GPT มักจะติดอยู่ในลูปการประมวลผลแทนที่จะสร้างผลลัพท์ออกมาตามที่สัญญาเอาไว้

ถึงแม้มันจะมีคุณสมบัติที่ดี ขอบเขตการแก้ปัญหาของ Auto-GPT ก็จะถูกจำกัดด้วยฟังก์ชั่นการใช้งานที่แคบลงและความสามารถในการให้เหตุผลที่ยังไม่สมบูรณ์แบบของ GPT-4

ซอร์สโค้ดของ Auto-GPT ระบุถึงชุดฟังก์ชั่นการทำงานที่จำกัด — ซึ่งรวมไปถึงการค้นหาเว็บ, การจัดการหน่วยความจำ, การโต้ตอบกับไฟล์, การใช้โค้ด, และการสร้างภาพ — ซึ่งเป็นการลดขอบเขตของงานที่สามารถจัดการได้อย่างมีประสิทธิภาพลง ยิ่งไปกว่านั้น ถึงแม้ว่า GPT-4 จะมีการปรับปรุงให้ดีขึ้นกว่ารุ่นก่อน แต่ความสามารถในการให้เหตุผลก็ยังห่างไกลจากอุดมคติที่ผู้คนคาดหวังไว้ ซึ่งมักส่งผลให้เกิดการวนลูปแทนที่จะเป็นวิธีการแก้ปัญหา

ความสามารถของ Auto-GPT

Auto-GPT ได้ก้าวข้ามขีดจำกัดของแชทบอท AI “ทั่วไป” อย่าง ChatGPT ตัวอย่างเช่น มันมีศักยภาพในการดูแลและดำเนินการการพัฒนาซอฟต์แวร์แอปพลิเคชั่นได้อย่างสมบูรณ์แบบ ในทำนองเดียวกัน ในเชิงธุรกิจและการจัดการ Auto-GPT สามารถเพิ่มมูลค่าสุทธิของบริษัทได้โดยพิจารณาจากการดำเนินงานและให้คำแนะนำเชิงลึกในเรื่องการปรับปรุงต่าง ๆ

ความสามารถในการเข้าถึงอินเทอร์เน็ตได้ของ Auto-GPT ทำให้มันสามารถดำเนินการต่าง ๆ ได้มากมาย เช่น การวิจัยตลาดหรือการเปรียบเทียบผลิตภัณฑ์ตามกฏเกณฑ์ที่ระบุไว้ ยิ่งไปกว่านั้น Auto-GPT ยังสามารถปรับปรุงตัวเองได้ สามารถสร้าง, ประเมิน, ตรวจทาน, และทดสอบการอัปเดตจากโค้ดของมันเองได้ ซึ่งอาจจะเป้นการช่วยเพิ่มประสิทธิภาพและความสามารถในการทำงานของมันได้ AI ยังสามารถเร่งกระบวนการสร้าง LLM ที่เหนือกว่าได้ ซึ่งจะเป็นการวางรากฐานให้กับผู้ช่วย AI ในรุ่นต่อ ๆ ไป

สรุปการใช้งานของ Auto-GPT

ตั้งแต่การสร้างพอดแคสต์และการวิเคราะห์หุ้น ไปจนถึงการเขียนซอฟต์แวร์และพัฒนาบอท AI ผู้ใช้งานทั่วโลกสามารถนำ Auto-GPT ไปใช้ได้อย่างสร้างสรรค์ในทุกสาขาวิชา หัวข้อการใช้งาน Auto-GPT ที่พบได้บ่อยที่สุดจนถึงปัจจุบัน ได้แก่ (ไม่ได้มีเพียงแค่นี้):

- การพัฒนาเว็บไซต์

- การสร้างบล็อกและบทความโดยป้อนข้อมูลให้น้อยที่สุด

- การสร้างกลยุทธ์ทางการตลาดที่มีประสิทธิภาพ

- การโต้ตอบกับผู้ใช้งานโดยอัตโนมัติ เช่น การรีวิวผลิตภัณฑ์หรือหนังสือ

- การออกแบบภาพกราฟิกและโลโก้ในเชิงธุรกิจโดยใช้โปรแกรมสร้างภาพด้วย AI เช่น DALL-E 2 และ Midjourney

- การพัฒนาอินเทอร์เฟสการสนทนาและแชทบอท

Auto-GPT vs. ผู้ช่วย AI ตัวอื่น ๆ

Auto-GPT ไม่ใช่ผู้ช่วย AI อัตโนมัติตัวเดียวที่มีอยู่ มันยังมีผู้ช่วย AI ตัวอื่น ๆ อยู่อีกมากมาย ซึ่งแต่ละตัวก็มีเสน่ห์และข้อจำกัดที่แตกต่างกันไป ต่อไปนี้คือตัวเลือกในการใช้งานแทน Auto-GPT ที่ได้รับความนิยมมากที่สุด 3 ตัวเลือก:

BabyAGI

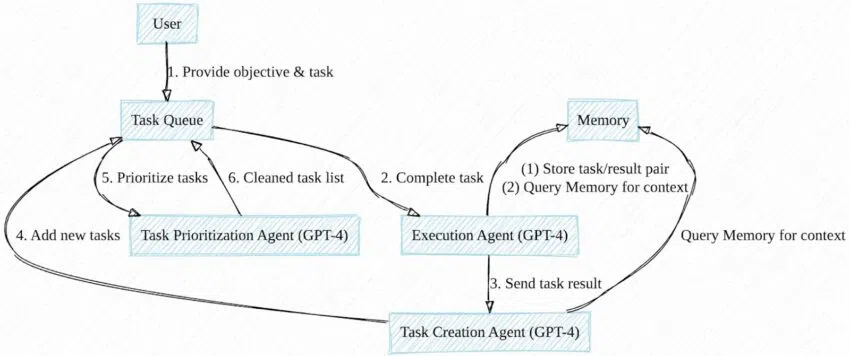

BabyAGI ซึ่งเป็นผลงานของ Yohei Nakajima ซึ่งโฮสต์อยู่บน GitHub เช่นเดียวกันกับ Auto-GPT มันจะช่วยสร้าง, จัดลำดับความสำคัญ, และดำเนินงานให้สอดคล้องกับวัตถุประสงค์ที่ตั้งไว้โดยอัตโนมัติ คุณต้องใช้ซอฟต์แวร์ Docker และคีย์ API จาก OpenAI หรือ Pinecone เพื่อเข้าถึงและใช้งานเครื่องมือนี้

โดยพื้นฐานแล้ว BabyAGI เป็นแบบจำลองทางภาษาที่เชื่อมต่อกับลิสต์ของงาน โดยจะจัดเก็บงานที่เสร็จสมบูรณ์ไว้ในฐานข้อมูล ทำหน้าที่เป็น “หน่วยความจำ” ของแบบจำลองสำหรับ “บริบท” เมื่อมีการกำหนดและดำเนินการงานใหม่ ถึงแม้ว่าสคริปต์พื้นฐานจะไม่มีความสามารถในการศึกษาข้อมูลจากอินเทอร์เน็ตหรือความสามารถในการเรียกใช้โค้ดอัตโนมัติ แต่ความสามารถเหล่านี้ก็มีอยู่ในเวอร์ชั่นย่อยที่แยกออกมา

Microsoft JARVIS

Microsoft JARVIS หรือที่รู้จักกันในชื่อ HuggingGPT เป็นระบบแบบจำลอง AI หลายตัวซึ่งมีแบบจำลอง GPT จาก OpenAI ทำหน้าที่เป็นตัวควบคุม

JARVIS เป็นการรวมแบบจำลองโอเพ่นซอร์สต่างๆ สำหรับการประมวลผลภาพ, วิดีโอ, เสียง, และอื่นๆ อีกมากมาย มันสามารถเชื่อมต่ออินเทอร์เน็ตและเข้าถึงไฟล์ได้ และเช่นเดียวกับ BabyAGI และ Auto-GPT มันสามารถประเมินงานและเลือกรูปแบบที่เหมาะสมที่สุดสำหรับการทำงานให้สำเร็จได้

AgentGPT

AgentGPT เป็นส่วนขยายบนเว็บไซต์ซึ่งมีคอนเซปต์ของ Auto-GPT/BabyAGI คุณสามารถเรียกใช้งานผู้ช่วยอัตโนมัติของคุณผ่านเบราว์เซอร์โดยทำตามคำแนะนำต่างๆ ได้

จากการอัปเดตครั้งล่าสุด AgentGPT มีคุณสมบัติดังนี้:

- หน่วยความจำระยะยาวที่สนับสนุนโดยดาต้าเบส

- การท่องและการโต้ตอบกับเว็บไซต์และบุคคล

- การบันทึกการทำงานของผู้ช่วย

ผลกระทบของ Auto-GPT ที่มีต่ออนาคตของ AI

Auto-GPT และผู้ช่วยอัจฉริยะที่คล้าย ๆ กันน่าจะเป็นตัวแทนการวิวัฒนาการของ AI ในรุ่นถัดไป เราอาจจะได้เห็นเครื่อง AI ที่มีความสร้างสรรค์, ประณีต, หลากหลาย และใช้งานได้จริงมากขึ้นในอนาคตอันใกล้ พัฒนาการเหล่านี้มีศักยภาพที่จะเปลี่ยนแปลงรูปแบบการทำงาน, การพักผ่อน, และการสื่อสารได้ อย่างไรก็ตาม มันไม่ได้นำเสนอการแก้ปัญหาความท้าทายดั้งเดิมที่มีอยู่ใน AI มาตั้งแต่กำเนิด ไม่ว่าจะเป็นความไม่แม่นยำของผลลัพท์, โอกาสที่จะละเมิดทรัพย์สินทางปัญหา, และแม้แต่การใช้ AI ไปในทางที่ผิดในการเผยแพร่เนื้อหาที่มีความเอนเอียงหรือเป็นอันตราย

สำหรับเรื่องความคุกคามของผู้ช่วย AI ที่มันอาจจะมีการพัฒนาไปสู่จุดที่มีความฉลาดเป็นอย่างมาก Max Tegmark นักฟิสิกส์และนักเขียนระดับ Best-Seller อธิบายถึงความเป็นได้นี้ในหนังสือ “Life 3.0” ของเขาในปี 2017 ว่า

“ข้อกังวลที่แท้จริงไม่ใช่เรื่องความมุ่งร้าย แต่เป็นความสามารถของมันซะมากกว่า AI ที่มีความฉลาดขั้นสุดนั้นจะเก่งกาจเป็นอย่างยิ่งในการบรรลุเป้าหมายต่าง ๆ ของมัน ไม่ว่าจะเป็นอะไรก็ตาม ดังนั้น สิ่งสำคัญคือเราต้องทำให้แน่ใจว่าเป้าหมายนั้นสอดคล้องกับเป้าหมายของเรา”